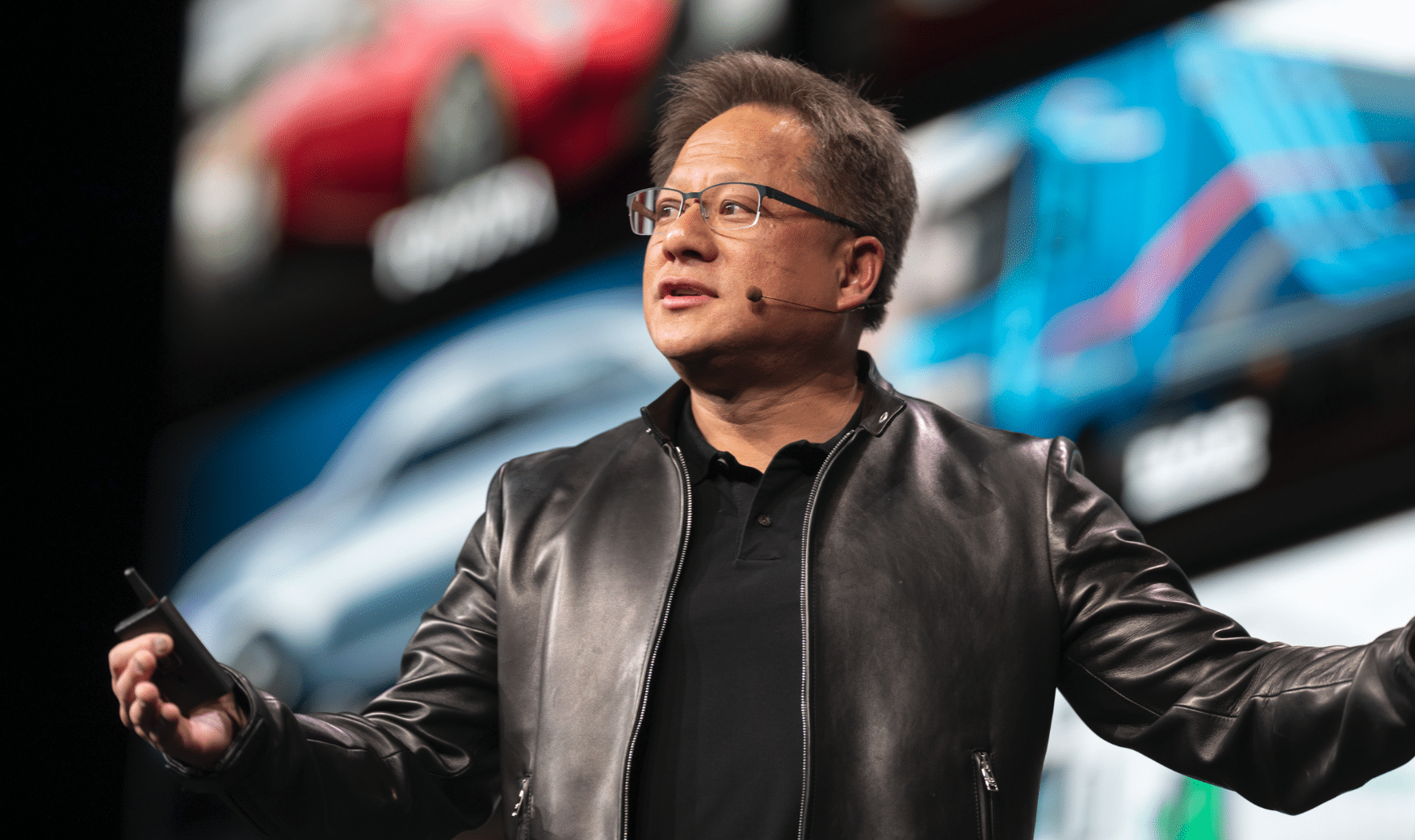

Jensen Huang y el Paradigma del Liderazgo Tecnológico: Entre la Innovación Disruptiva y las Tensiones del Capitalismo Digital

El ascenso de Nvidia hacia una valoración de cinco billones de dólares plantea interrogantes fundamentales sobre la concentración de poder económico, las dinámicas laborales en el sector tecnológico y el rol de la inteligencia artificial como vector de transformación estructural